被リンク(外部リンク)とは?ツールを使った調べ方とSEOへの影響

2019年8月6日

東証スタンダード上場企業のジオコードが運営!

SEOがまるっと解るWebマガジン

更新日:2022年 11月 09日

ロボット型検索エンジンとは?クローラーが巡回する仕組みや重視するポイントを解説!

ロボット型検索エンジンとは?クローラーが巡回する仕組みや重視するポイントを解説!

【監修】株式会社ジオコード SEO事業 責任者

栗原 勇一

近年、日常生活で情報を入手する際にインターネットを利用する人が多くなってきました。情報を得ようと何気なく使用している検索エンジンの主流はロボット型検索エンジンと呼ばれ、ユーザーが検索したキーワードに一致する内容のWebページを探し出してくれています。

このページではロボット型検索エンジンの仕組みや重視するポイントについて解説していきます。

Webサイトの運営をしている方であれば、自身のWebサイトへの流入数を増加させるためにも、ロボット型検索エンジンについて理解し、検索エンジンの検索結果で上位表示を目指すことで運営に役立てていきましょう。

また、検索エンジンの仕組みについて詳しく知りたい方のために、資料をご用意しています。

あわせてご覧ください。

目次

ロボット型検索エンジンとはインターネット上にある世界中のWebサイト情報を自動的に収集して、ユーザーが検索したキーワードをもとに、収集した情報から適切だと判断されたものを検索結果として表示する仕組みのことです。

GoogleやYahoo!などの主要な検索エンジンはほぼこのロボット型検索エンジンが導入されています。

検索エンジンでは検索結果の順位付けの際に判断基準となるアルゴリズムが定められていますが、その具体的な内容は一般に公開されていません。また、アルゴリズムも定期的にアップデートが行われるため、内容は年々複雑になっています。

実際にユーザーがロボット型検索エンジンを利用してキーワード検索を行うと、インターネット上にあるそのキーワードに合った内容のWebページを検索結果に表示してくれます。例えば「ソフトウェア 開発」というキーワードを検索した場合には、検索エンジンがソフトウェアの開発に関わる情報をまとめたページや、ソフトウェア開発を行っている会社などを検索結果に表示します。検索するキーワードは単体キーワードと複合キーワードのどちらでも検索ができます。

検索エンジンにはロボット型検索エンジンの他にディレクトリ型検索エンジンがあります。ディレクトリ型検索エンジンは手動で情報収集と分類を行う検索エンジンのことを指します。

自動で情報収集をするロボット型検索エンジンに対して、手動でWebページがカテゴリー分けされているので、特定の分野などの限定的なWebサイトが探しやすく、人が介入することで有益な価値のあるWebサイトが検索結果に表示されます。

以前は検索エンジンの主流であったディレクトリ型検索エンジンですが、現在ではインターネットの利用者やWebサイト情報が増加したことによってディレクトリ型検索エンジンでは対応しきれなくなり、性能の上がったロボット型検索エンジンが主流となりました。

ここではロボット型検索エンジンがWebサイトを巡回して、情報を収集していく仕組みとその特徴について解説します。

まずは仕組みについてです。ロボット型検索エンジンでは「クローリング」「インデクシング」「クエリープロセス」という3つの工程を踏んで検索システムへ情報が提供されます。

最初に「クローリング」という工程でクローラーまたはスパイダーと呼ばれるロボットがインターネット上にあるWebサイトを自動で巡回し、情報を収集します。

次に「インデクシング」でクローラーによって集められたHTML上のタグや画像、文字情報などを記録、分解、解析されてデータベースに登録(インデックス)されます。この工程はユーザーが検索を行う前に完了されており、Webページが整理されることによってインターネットの高速利用が可能になります。

最後に「クエリープロセス」ではインデックスされた情報をもとに、検索キーワードによって優先順位をつけてWebページを表示します。実際にユーザーがキーワードで検索をかけるとアルゴリズムに基づいてインデックスされたWebページの順位付けが行われ、最終調整が行われた後に順位の高いものから検索結果に表示される、という流れになります。

続いて、ロボット型検索エンジンの特徴は、原理としては世界中のWebページをクローラーが巡回することが可能な点です。これによってユーザーは膨大な情報の中から自身が探している情報を検索することができます。また、クローリングは定期的に行われるため、最新の情報を検索することが可能です。

しかし、扱っている情報の量が膨大なために検索キーワードによっては、検索エンジンがユーザーの意図を読み取れず、ユーザーが求めている情報とは異なるWebページが検索結果に表示されていしまうこともあります。

SEO対策において、ロボット型検索エンジンが何を重視してWebページの評価を決めているのかを理解することは重要です。評価されている内容を踏まえてWebページを作成することで運営しているWebサイトが検索結果で上位に表示されやすくなる可能性があります。

過去、重視されているといわれていたものとしては被リンクが挙げられます。

被リンクが重視される理由は、そのコンテンツが有益であれば、ユーザーがそのコンテンツのリンクを自身のコンテンツに貼って解説などを行うため、そのコンテンツをGoogleが有益だと評価するためです。

しかし、現在では被リンクの評価以外にも、下記の点が重視されていると言われています。

ロボット型検索エンジンのクローラーはインターネット上のWebサイトを巡回して、様々なWebページを自然言語処理機能を使用して分析し、そのWebページに何が書かれているのかを分解して学習しています。つまり、GoogleはWebページのコンテンツの内容を理解しているのです。

そのため、高い評価を得るためのコンテンツ作成として注意したいのが文字数と質です。コンテンツを作成する際には、コンテンツの情報量と質を上げることが重要とされており、それらを上げるために文字数を多くすることによる利点は2つあります。

1つ目はロングテールキーワードの増加が見込めることです。

ロングテールキーワードとは、流行に左右されず、検索される回数は少ないものの、長く検索されるキーワードのことです。ロングテールキーワードが増加すると検索結果での表示回数も増加し、自然検索での流入数の増加が見込めます。

2つ目はそのコンテンツのユーザーの直帰率や滞在時間の改善です。

直帰率が低い、滞在時間が長いということは、そのWebページをユーザーがしっかりと読んでいるということになります。そのため、そのページは作りこまれた有益な情報が載っているページだとGoogleが認識することで評価される可能性があります。

コンテンツの情報量と質が高い評価を得るために必要とされていますが、文字数がそこまで多くないWebページが評価されている場合もあります。それはユーザーが得たいと思っている情報を提供していて、さらに他のWebサイトで参照されて被リンクを多く獲得している場合です。そのようなコンテンツであれば文字数は関係ないとされています。はじめからそのようなコンテンツを作成することは容易ではないため、ユーザーが得たいと思う情報を含むために必要な文字数を考え、コンテンツを充実させることを心掛けましょう。

また、作成しただけではなく、定期的に文字数や内容を精査して、コンテンツのリライトを行い、質を高めていくこともそのWebページが評価を得るためには重要です。

今回は検索エンジンの主流となっているロボット型検索エンジンについて解説をしてきました。

Webサイトを運営するにあたって、検索結果に自身のWebサイトが上位表示されることは、セッション数を増やすために欠かせないポイントです。そのためにはロボット型検索エンジンのクローラーがどのようなWebサイトを評価しているのかを理解することが重要です。そしてコンテンツ作成時には評価ポイントとなるそのコンテンツの文字数や質、滞在時間などを考えたユーザーにとって有益な内容を織り交ぜられるように心掛けてください。

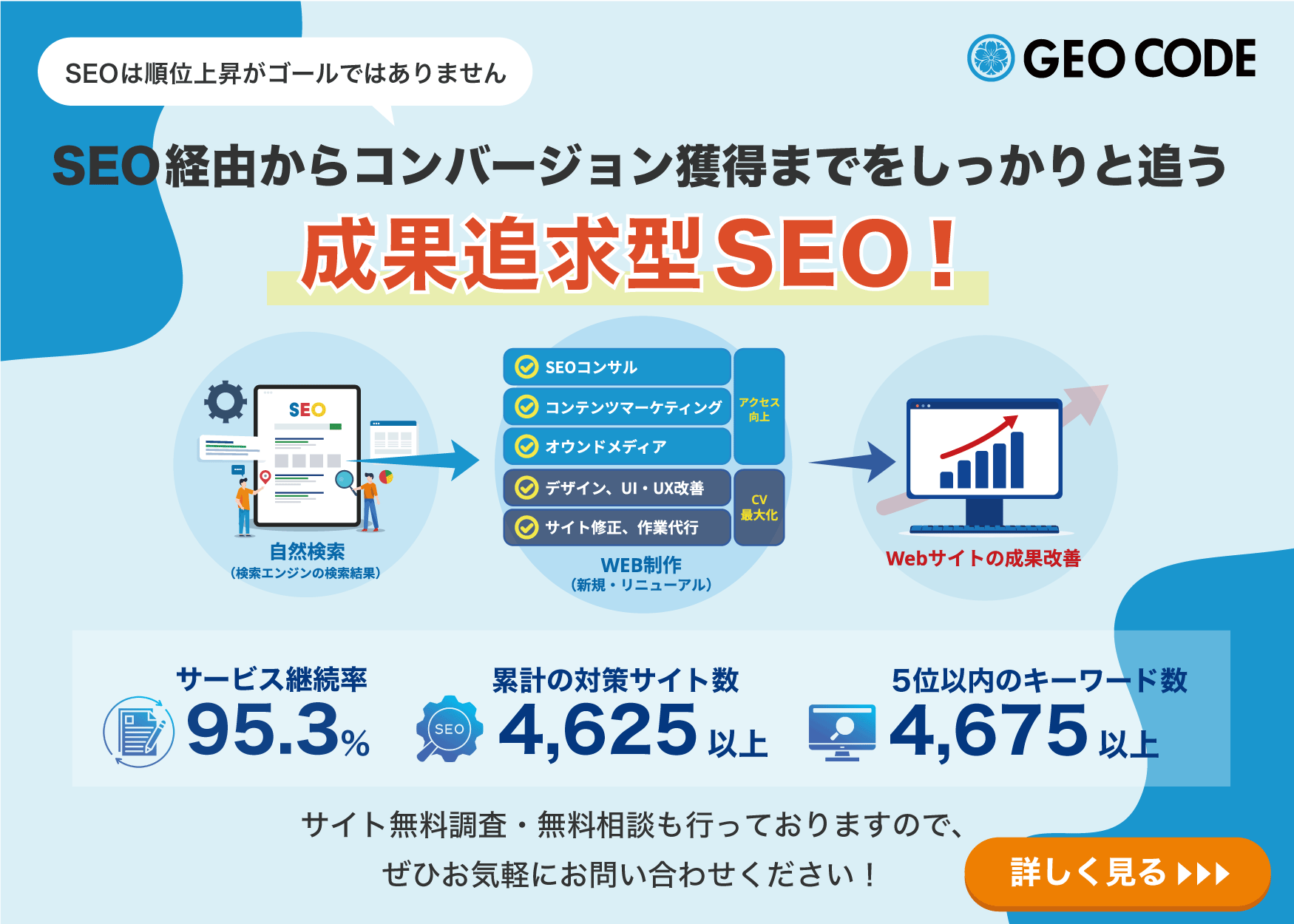

また「SEOの対応方法が分からない」「自分でやるのは難しい」とお悩みの方には業者に頼るのも手段です。各地域のSEO業者をまとめた記事も用意してみました。こちらも参考になれば幸いです。

もちろん、当社にご相談いただけても嬉しいです!気兼ねなくご連絡ください!

【参考サイト】

ロボット型検索エンジンとは?Webクローラー自動巡回の仕組み

ロボット型検索エンジンは、現代のインターネット生活に欠かせない

ロボット型検索エンジンのしくみ | tree

ロボット型検索エンジンとは何? Weblio辞書

ロボット型検索エンジン

被リンクのSEO効果とは?良質・悪質な被リンクの見極めが重要!

コンテンツSEOとは何か?わかりやすく解説!|SEOラボ

ページの滞在時間はSEO順位に影響する?コンテンツの滞在時間と直帰率を改善する方法 | プロモニスタ